El director ejecutivo de OpenAI, Sam Altman, respondió a una solicitud de la Comisión Federal de Comercio como parte de una investigación para determinar si la empresa «participó en prácticas desleales o engañosas» relacionadas con la privacidad, la seguridad de los datos y los riesgos de daño al consumidor, particularmente en relación con la reputación.

es muy decepcionante ver que la solicitud de la FTC comienza con una filtración y no ayuda a generar confianza.

Dicho esto, es muy importante para nosotros que nuestra tecnología sea segura y pro-consumidor, y estamos seguros de que cumplimos con la ley. por supuesto que trabajaremos con la FTC.

— Sam Altman (@sama) 13 de julio de 2023

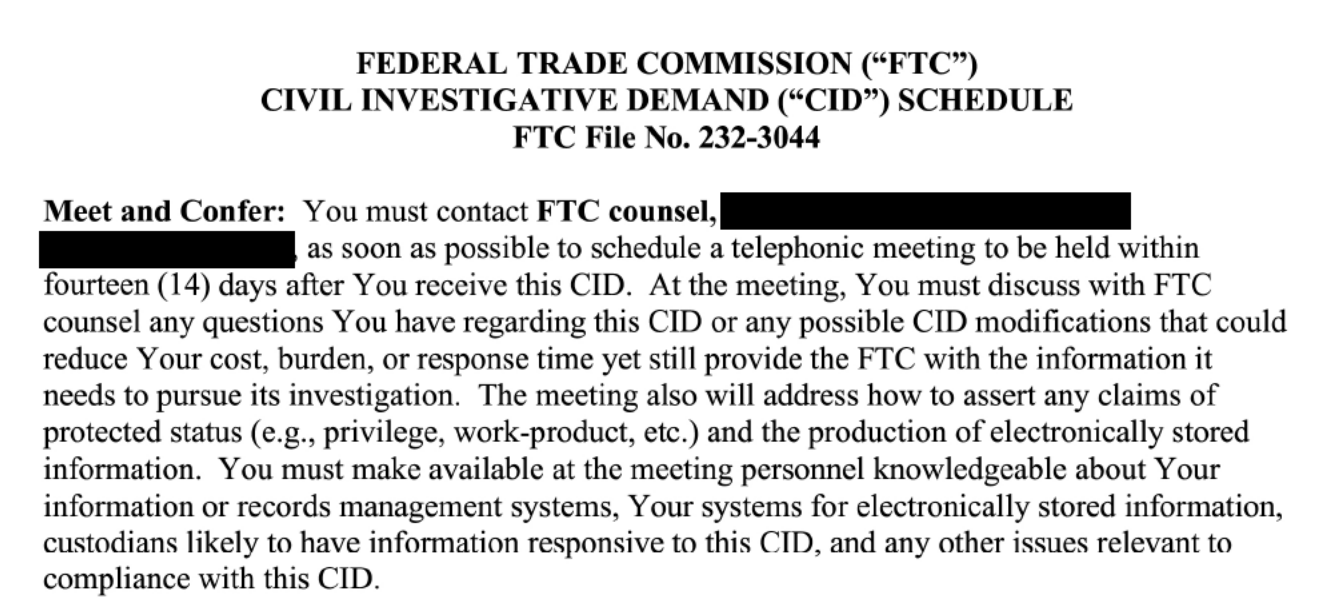

La FTC ha solicitado información de OpenAI que se remonta a junio de 2020, como se revela en un documento filtrado obtenido por la El Correo de Washington.

Captura de pantalla del Washington Post, julio de 2023

Captura de pantalla del Washington Post, julio de 2023El tema de la investigación: ¿Violó OpenAI Sección 5 de la Ley de la FTC?

La documentación que OpenAI debe proporcionar debe incluir detalles sobre la capacitación, el refinamiento, el refuerzo a través de comentarios humanos, la confiabilidad de la respuesta y las políticas y prácticas relacionadas con la privacidad, la seguridad y la mitigación de riesgos del consumidor.

somos transparentes sobre las limitaciones de nuestra tecnología, especialmente cuando nos quedamos cortos. y nuestra estructura de ganancias limitadas significa que no tenemos incentivos para obtener rendimientos ilimitados.

— Sam Altman (@sama) 13 de julio de 2023

La creciente preocupación de la FTC por la IA generativa

La investigación sobre las prácticas de una importante empresa de inteligencia artificial no sorprende. El interés de la FTC en los riesgos de la IA generativa ha ido en aumento desde que ChatGPT se disparó en popularidad.

Atención a la tecnología de toma de decisiones automatizada

En abril 2021la FTC publicó una guía sobre inteligencia artificial (IA) y algoritmos, advirtiendo a las empresas que se aseguren de que sus sistemas de IA cumplan con las leyes de protección al consumidor.

Señaló la Sección 5 de la Ley de la FTC, la Ley de informes crediticios justos y la Ley de igualdad de oportunidades crediticias como leyes importantes para los desarrolladores y usuarios de IA.

La FTC advirtió que los algoritmos basados en datos sesgados o una lógica defectuosa podrían generar resultados discriminatorios, incluso si no fueron intencionados.

La FTC describió las mejores prácticas para el desarrollo ético de la IA en función de su experiencia en la aplicación de las leyes contra las prácticas injustas, el engaño y la discriminación.

Las recomendaciones incluyen probar los sistemas para detectar sesgos, permitir auditorías independientes, limitar las afirmaciones de marketing exageradas y sopesar los daños sociales frente a los beneficios.

“Si su algoritmo da como resultado una discriminación crediticia contra una clase protegida, podría encontrarse frente a una queja alegando violaciones de la Ley FTC y ECOA”, advierte la guía.

IA bajo control

La FTC recordó a las empresas de IA sobre su guía de IA de 2021 con respecto a hacer afirmaciones de marketing exageradas o sin fundamento con respecto a las capacidades de IA.

En la publicación de febrero 2023la organización advirtió a los especialistas en marketing que no se dejen llevar por la exageración de la IA y hagan promesas que sus productos no pueden cumplir.

Problemas comunes citados: afirmar que la IA puede hacer más de lo que permite la tecnología actual, hacer comparaciones no respaldadas con productos que no son de IA y no probar los riesgos y los sesgos.

La FTC enfatizó que la comercialización falsa o engañosa constituye una conducta ilegal independientemente de la complejidad de la tecnología.

El recordatorio llegó unas semanas después de que ChatGPT de OpenAI alcanzara los 100 millones de usuarios.

La FTC también publicó una lista de trabajos para tecnólogos en esta época, incluidos aquellos con experiencia en inteligencia artificial, para respaldar investigaciones, iniciativas de políticas e investigación sobre protección del consumidor y competencia en la industria tecnológica.

Deepfakes y engaños

Alrededor de un mes después, en Marzola FTC advirtió que las herramientas generativas de inteligencia artificial como los chatbots y los deepfakes podrían facilitar el fraude generalizado si se implementan de manera irresponsable.

Advirtió a los desarrolladores y empresas que utilizan medios sintéticos e IA generativa que consideren los riesgos inherentes del mal uso.

La agencia dijo que los malos actores pueden aprovechar el contenido realista pero falso de estos sistemas de IA para estafas de phishing, robo de identidad, extorsión y otros daños.

Si bien algunos usos pueden ser beneficiosos, la FTC instó a las empresas a sopesar la fabricación o venta de tales herramientas de IA dada la explotación criminal previsible.

La FTC aconsejó que las empresas que continúan desarrollando o utilizando IA generativa deben tomar precauciones estrictas para evitar el abuso.

También advirtió contra el uso de medios sintéticos en marketing engañoso y no revelar cuándo los consumidores interactúan con chatbots de IA en lugar de personas reales.

AI propaga software malicioso

En Abrilla FTC reveló cómo los ciberdelincuentes explotaron el interés en la IA para propagar malware a través de anuncios falsos.

Los anuncios falsos promocionaban herramientas de inteligencia artificial y otro software en las redes sociales y los motores de búsqueda.

Al hacer clic en estos anuncios, los usuarios acceden a sitios clonados que descargan malware o explotan puertas traseras para infectar dispositivos sin ser detectados. La información robada luego se vendió en la web oscura o se usó para acceder a las cuentas en línea de las víctimas.

Para evitar ser pirateado, la FTC aconsejó no hacer clic en los anuncios de software.

Si están infectados, los usuarios deben actualizar las herramientas de seguridad y los sistemas operativos, luego seguir los pasos para eliminar el malware o recuperar cuentas comprometidas.

La FTC advirtió al público que tenga cuidado con los ciberdelincuentes cada vez más sofisticados para propagar malware a través de redes publicitarias.

Las agencias federales se unen para abordar la regulación de la IA

Cerca del final de Abrilcuatro agencias federales, la Oficina de Protección Financiera del Consumidor (CFPB), la División de Derechos Civiles (DOJ) del Departamento de Justicia, la Comisión de Igualdad de Oportunidades en el Empleo (EEOC) y la FTC, emitieron una declaración sobre cómo monitorearían el desarrollo de IA y harían cumplir leyes contra la discriminación y el sesgo en los sistemas automatizados.

Las agencias afirmaron su autoridad sobre AI bajo las leyes existentes sobre derechos civiles, préstamos justos, igualdad de oportunidades y protección del consumidor.

Juntos, advirtieron que los sistemas de IA podrían perpetuar el sesgo ilegal debido a datos defectuosos, modelos opacos y elecciones de diseño inadecuadas.

La asociación tenía como objetivo promover la innovación de IA responsable que aumenta el acceso, la calidad y la eficiencia del consumidor sin violar las protecciones de larga data.

IA y confianza del consumidor

En Puedela FTC advirtió a las empresas contra el uso de nuevas herramientas generativas de inteligencia artificial como los chatbots para manipular las decisiones de los consumidores de manera injusta.

Después de describir los eventos de la película. ex machinala FTC afirmó que la persuasión similar a la humana de los chatbots de IA podría llevar a las personas a tomar decisiones dañinas sobre las finanzas, la salud, la educación, la vivienda y el trabajo.

Aunque no necesariamente intencional, la FTC dijo que los elementos de diseño que explotan la confianza humana en las máquinas para engañar a los consumidores constituyen prácticas desleales y engañosas según la ley de la FTC.

La agencia aconsejó a las empresas que eviten la antropomorfización excesiva de los chatbots y garanticen la divulgación de promociones pagas entretejidas en las interacciones de IA.

Con el aumento de la adopción de IA generativa, la alerta de la FTC advierte a las empresas que evalúen de manera proactiva los impactos sociales posteriores.

Esas herramientas que se apresuran a comercializarse sin una revisión ética adecuada o las protecciones pondrían en riesgo la acción de la FTC sobre el daño resultante al consumidor.

Una opinión sobre los riesgos de la IA

La presidenta de la FTC, Lina Khan, argumentó que la IA generativa presenta riesgos de afianzar un dominio tecnológico significativo, impulsar el fraude y automatizar la discriminación si no se controla.

En un artículo de opinión del New York Times publicado un Pocos diás después de la advertencia sobre la confianza del consumidor, Khan dijo que la FTC tiene como objetivo promover la competencia y proteger a los consumidores a medida que se expande la IA.

Khan advirtió que algunas empresas poderosas controlaban entradas clave de IA como datos y computación, lo que podría aumentar su dominio sin la vigilancia antimonopolio.

Advirtió que el contenido falso realista de la IA generativa podría facilitar estafas generalizadas. Además, los datos sesgados ponen en riesgo los algoritmos que excluyen ilegalmente a las personas de las oportunidades.

Si bien es novedoso, Khan afirmó que los sistemas de inteligencia artificial no están exentos de las autoridades antimonopolio y de protección al consumidor de la FTC. Con una supervisión responsable, Khan señaló que la IA generativa podría crecer de manera equitativa y competitiva, evitando las trampas de otros gigantes tecnológicos.

IA y privacidad de datos

En Juniola FTC advirtió a las empresas que las protecciones de privacidad del consumidor se aplican por igual a los sistemas de IA que dependen de datos personales.

En denuncias contra Amazonas y Anillola FTC alegó prácticas desleales y engañosas que utilizan datos de voz y video para entrenar algoritmos.

El presidente de la FTC, Khan, dijo que los beneficios de la IA no superan los costos de privacidad de la recopilación invasiva de datos.

La agencia afirmó que los consumidores retienen el control sobre su información incluso si una empresa la posee. Se esperan medidas de seguridad y controles de acceso estrictos cuando los empleados revisan datos biométricos confidenciales.

Para los datos de los niños, la FTC dijo que haría cumplir plenamente la ley de privacidad de los niños, COPPA. Las denuncias ordenaron la eliminación de los datos biométricos obtenidos de forma ilícita y cualquier modelo de IA derivado de ellos.

El mensaje para las empresas de tecnología fue claro: si bien el potencial de la IA es enorme, las obligaciones legales en torno a la privacidad del consumidor siguen siendo primordiales.

Competición de IA generativa

Cerca del final de Juniola FTC emitió una guía que advierte que el rápido crecimiento de la IA generativa podría generar preocupaciones sobre la competencia si los insumos clave quedan bajo el control de unas pocas empresas tecnológicas dominantes.

La agencia dijo que se necesitan insumos esenciales como datos, talento y recursos informáticos para desarrollar modelos de IA generativos de vanguardia. La agencia advirtió que si un puñado de grandes empresas de tecnología obtienen demasiado control sobre estos insumos, podrían usar ese poder para distorsionar la competencia en los mercados de IA generativa.

La FTC advirtió que las tácticas anticompetitivas como la agrupación, la vinculación, los acuerdos exclusivos o la compra de competidores podrían permitir que los titulares dejen de lado a los rivales emergentes y consoliden su liderazgo.

La FTC dijo que monitoreará los problemas de competencia relacionados con la IA generativa y tomará medidas contra las prácticas desleales.

El objetivo era permitir que los empresarios innovaran con tecnologías de IA transformadoras, como los chatbots, que podrían remodelar las experiencias de los consumidores en todas las industrias. Con las políticas correctas, la FTC creía que la IA generativa emergente puede generar todo su potencial económico.

Reclamaciones de marketing sospechosas

A comienzos de Juliola FTC advirtió sobre las herramientas de IA que pueden generar falsificaciones profundas, voces clonadas y aumento de texto artificial, por lo que también han surgido herramientas que afirman detectar dicho contenido generado por IA.

Sin embargo, los expertos advirtieron que las afirmaciones de marketing realizadas por algunas herramientas de detección pueden exagerar sus capacidades.

La FTC advirtió a las empresas que no exageren la precisión y confiabilidad de sus herramientas de detección. Dadas las limitaciones de la tecnología actual, las empresas deben asegurarse de que el marketing refleje evaluaciones realistas de lo que estas herramientas pueden y no pueden hacer.

Además, la FTC señaló que los usuarios deben tener cuidado con las afirmaciones de que una herramienta puede detectar todas las falsificaciones de IA sin errores. La detección imperfecta podría conducir a acusar injustamente a personas inocentes, como solicitantes de empleo, de crear contenido falso.

¿Qué descubrirá la FTC?

La investigación de la FTC sobre OpenAI se produce en medio de un creciente escrutinio regulatorio de los sistemas de IA generativa.

A medida que estas poderosas tecnologías habilitan nuevas capacidades como chatbots y deepfakes, plantean nuevos riesgos relacionados con el sesgo, la privacidad, la seguridad, la competencia y el engaño.

OpenAI debe responder preguntas sobre si tomó las precauciones adecuadas al desarrollar y lanzar modelos como GPT-3 y DALL-E que han dado forma a la trayectoria del campo de la IA.

La FTC parece estar enfocada en garantizar que las prácticas de OpenAI se alineen con las leyes de protección al consumidor, especialmente con respecto a las afirmaciones de marketing, las prácticas de datos y la mitigación de los daños sociales.

La forma en que responde OpenAI y si surge alguna acción de aplicación podría sentar precedentes significativos para la regulación a medida que avanza la IA.

Por ahora, la investigación de la FTC subraya que la exageración que rodea a la IA no debería superar a la supervisión responsable.

Los sistemas robustos de IA son muy prometedores, pero presentan riesgos si se implementan sin suficientes garantías.

Las principales empresas de inteligencia artificial deben garantizar que las nuevas tecnologías cumplan con las leyes de larga data que protegen a los consumidores y los mercados.

Imagen destacada: Ascannio/Shutterstock

#CEO #OpenAI #responde #investigación #FTC #medida #aumentan #las #preocupaciones #sobre